eechat-跨平台本地部署LLM工具,支持mcp接入

eechat-跨平台本地部署LLM工具,支持mcp接入

noiseeechat 是一款开源免费的国产 AI 应用,支持 Windows、macOS 和 Linux,集成了聊天、多模态指令执行(MCP)、知识库问答(RAG)、语音识别(ASR)、语音合成(TTS)等功能模块。

- 开箱即用,无需代码基础,适合非技术背景用户。

- 免费开源,国产的免费开源应用,数据都存储在本地

- 多模型支持,同时支持 API 模型和本地模型聊天,可以自定义配置自己喜欢的模型

- 丰富的支持,支持 MCP、RAG 和插件支持

🖥️ 下载 eecha

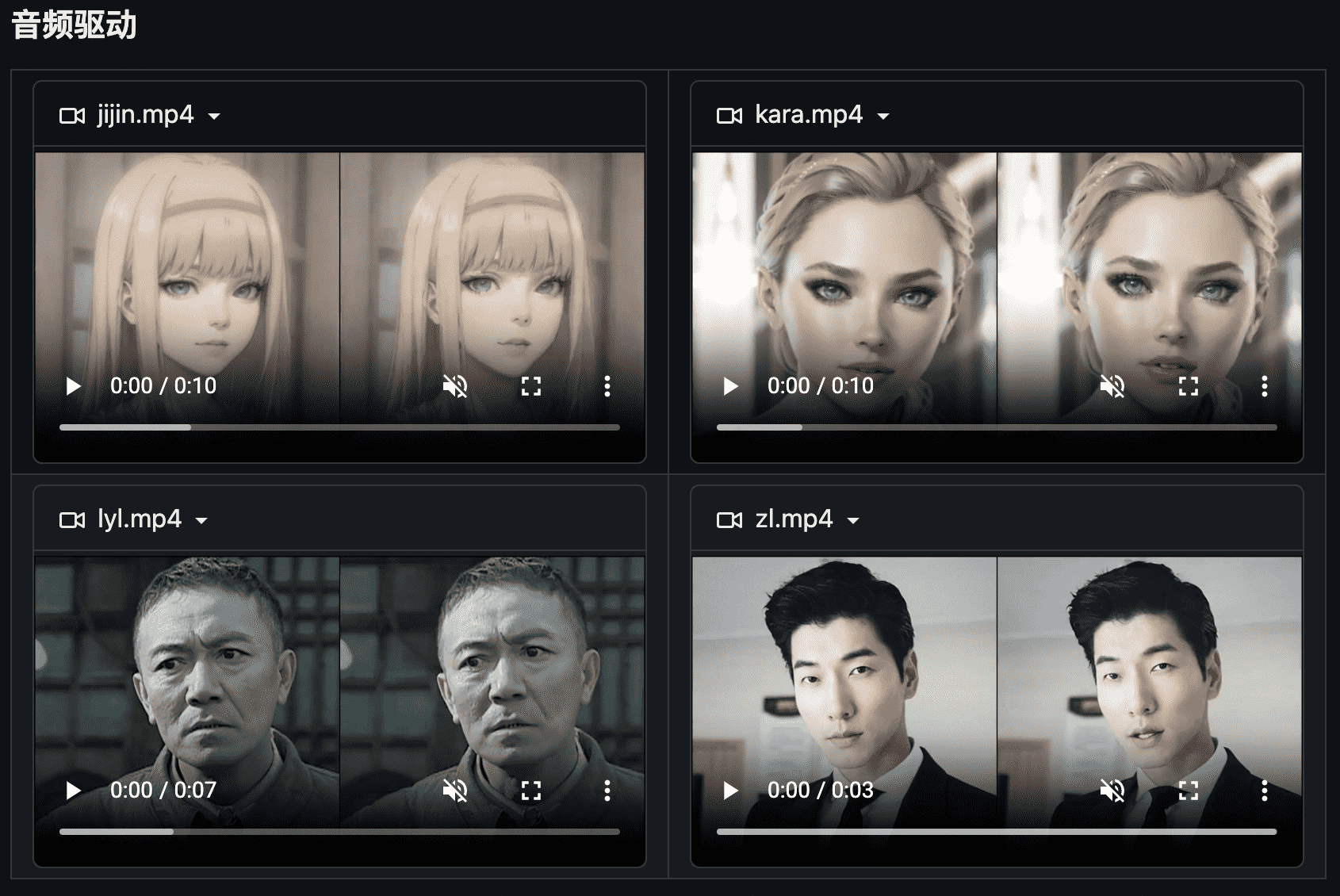

功能介绍

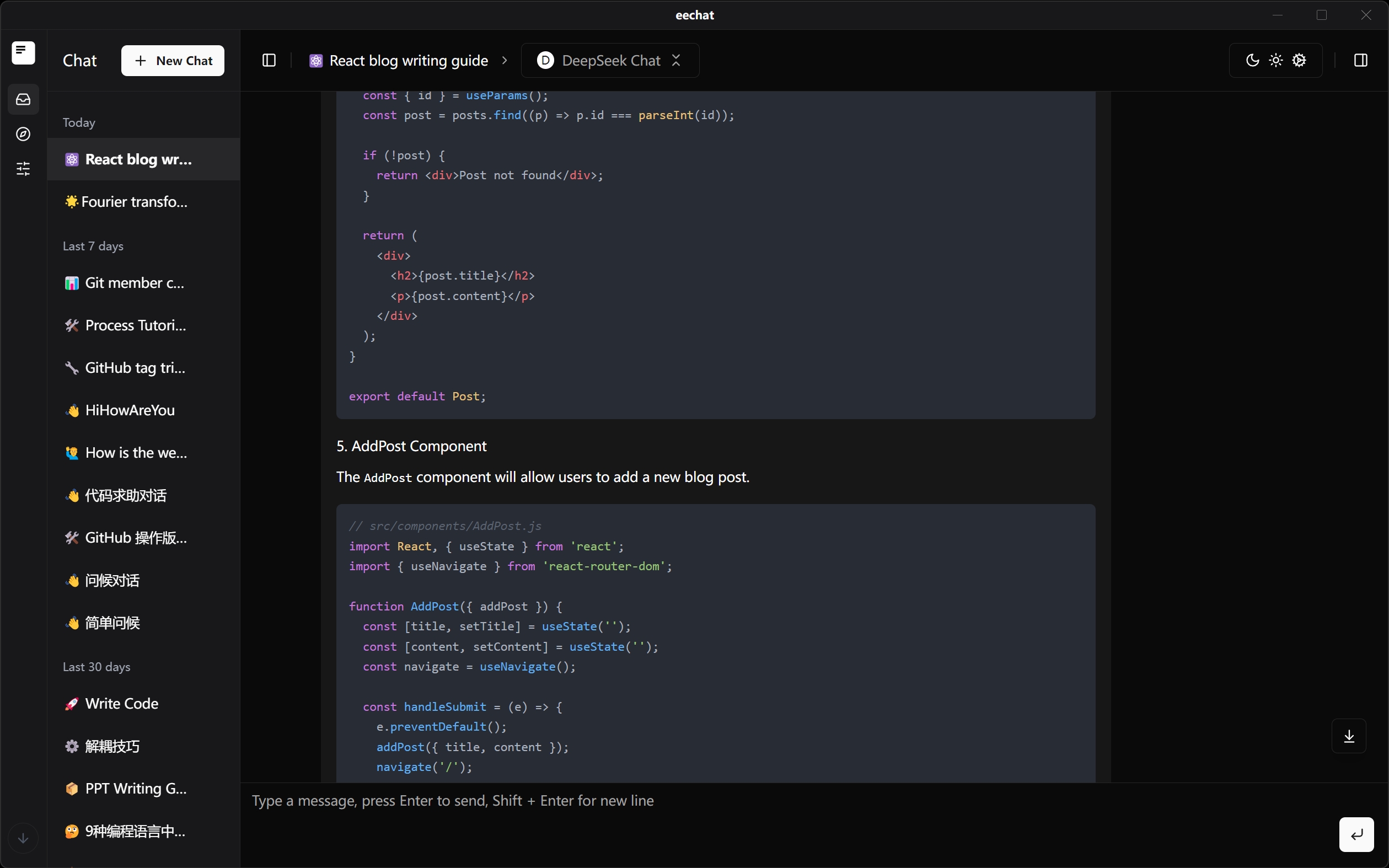

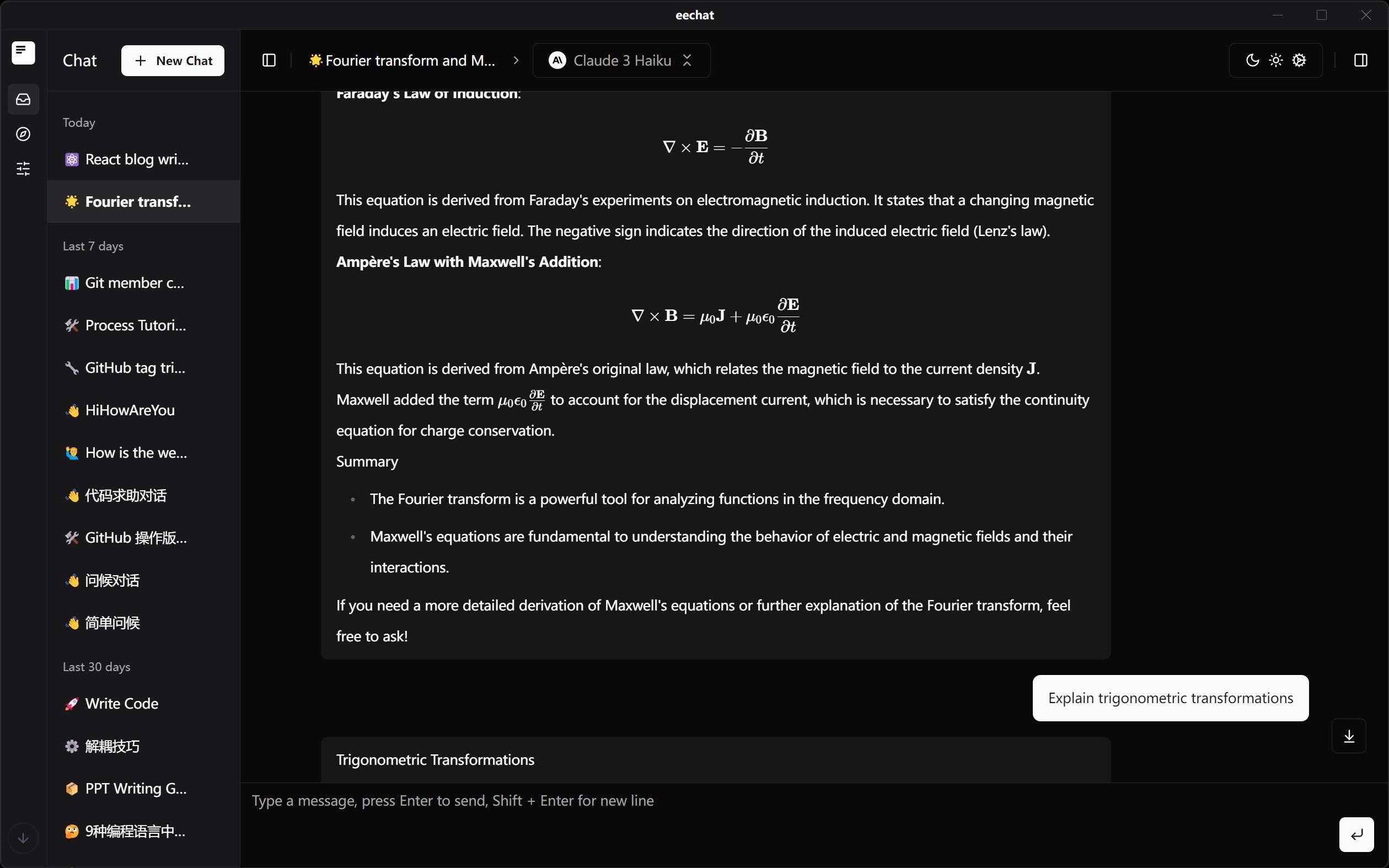

对话

基础 AI 对话能力,数据本地存储,支持上下文对话,提示词配置,模型参数配置等。

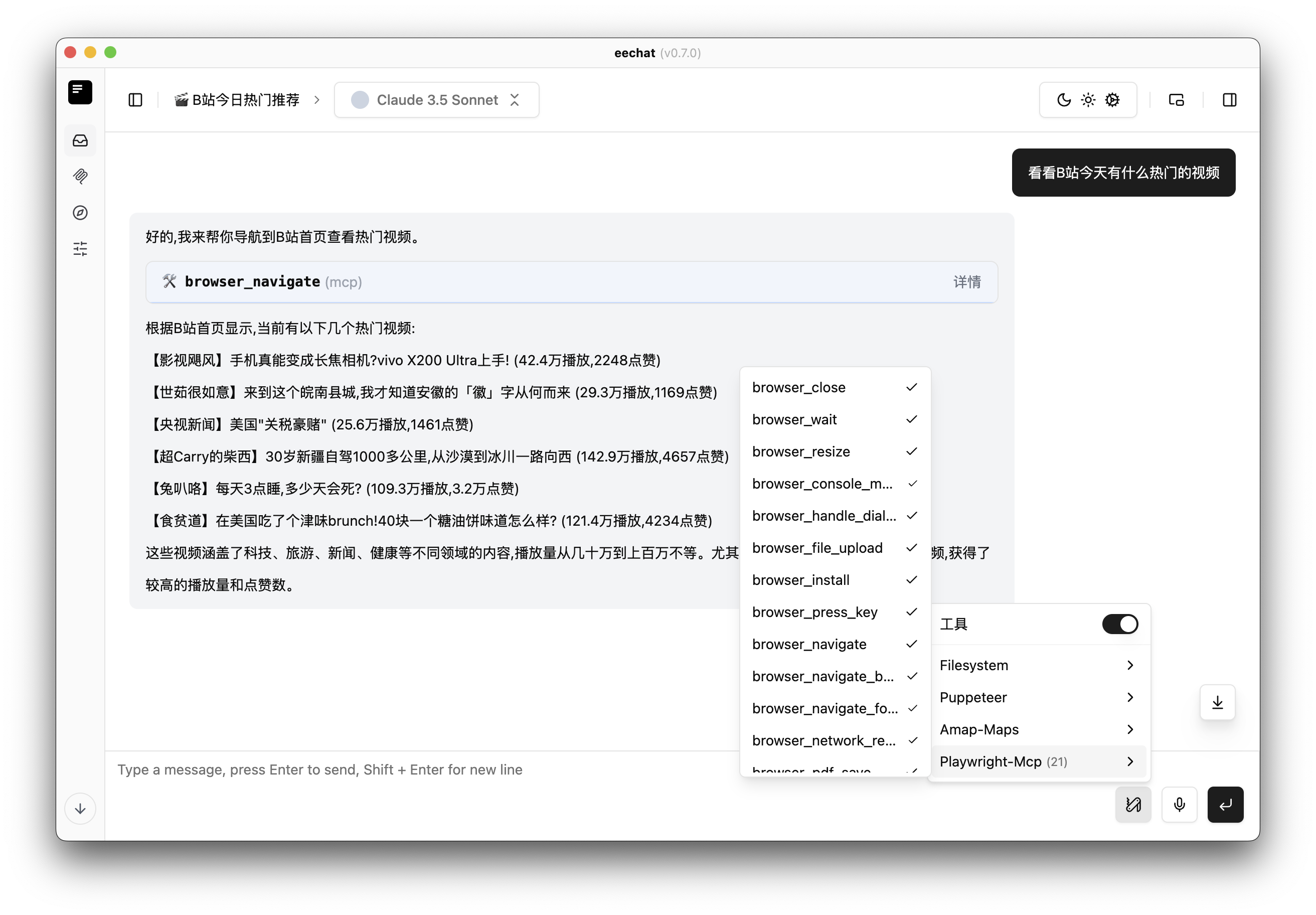

MCP 能力

MCP 功能,支持模型上下文协议,支持模型上下文的存储,支持模型上下文的共享,支持模型上下文的搜索等。

内置 MCP运行环境

内置 MCP 市场及常用工具

支持与 Claude Desktop 同步配置

本地模型

支持在自己的电脑上运行开源模型。

API 模型

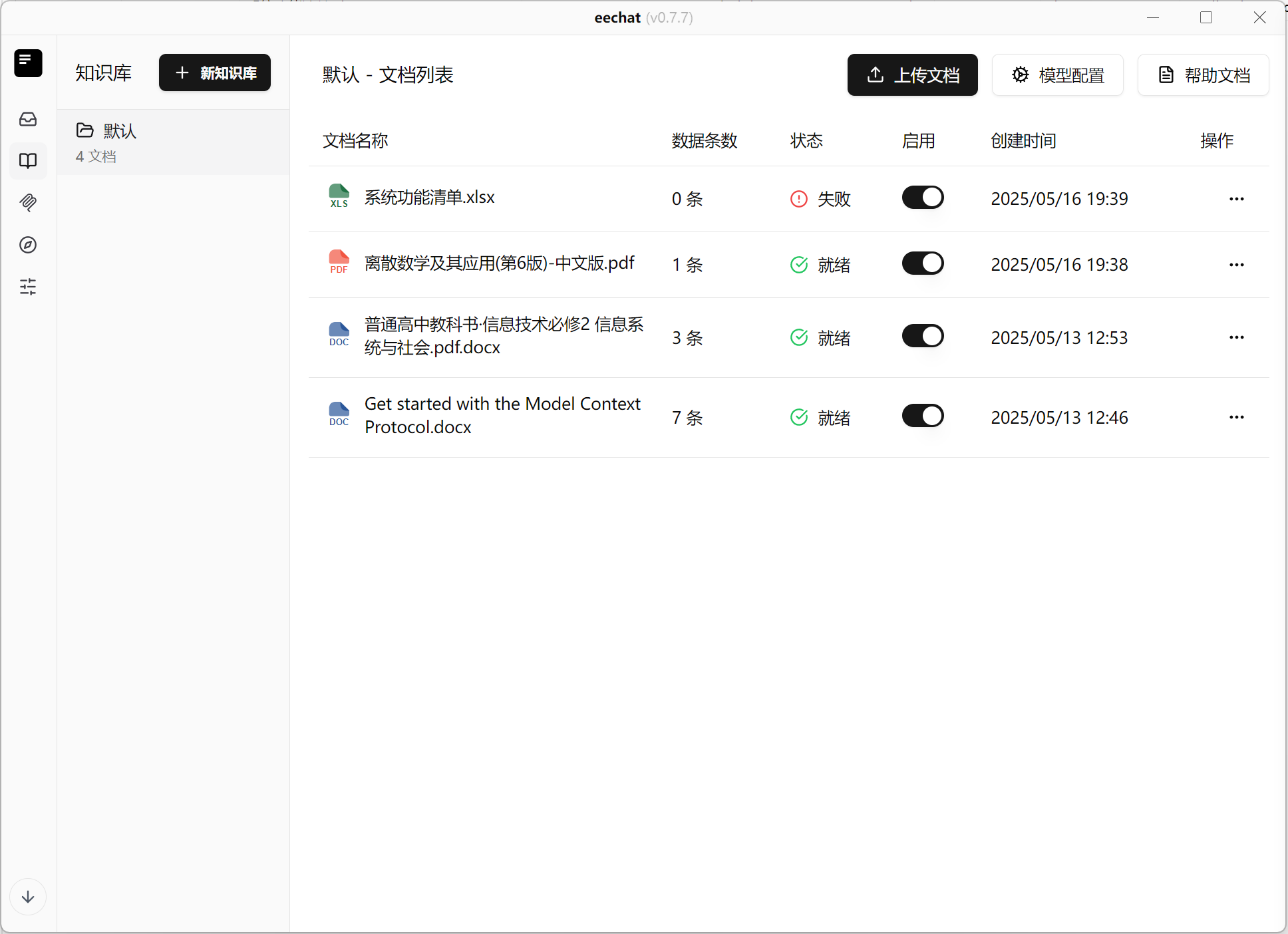

本地知识库

主要特性

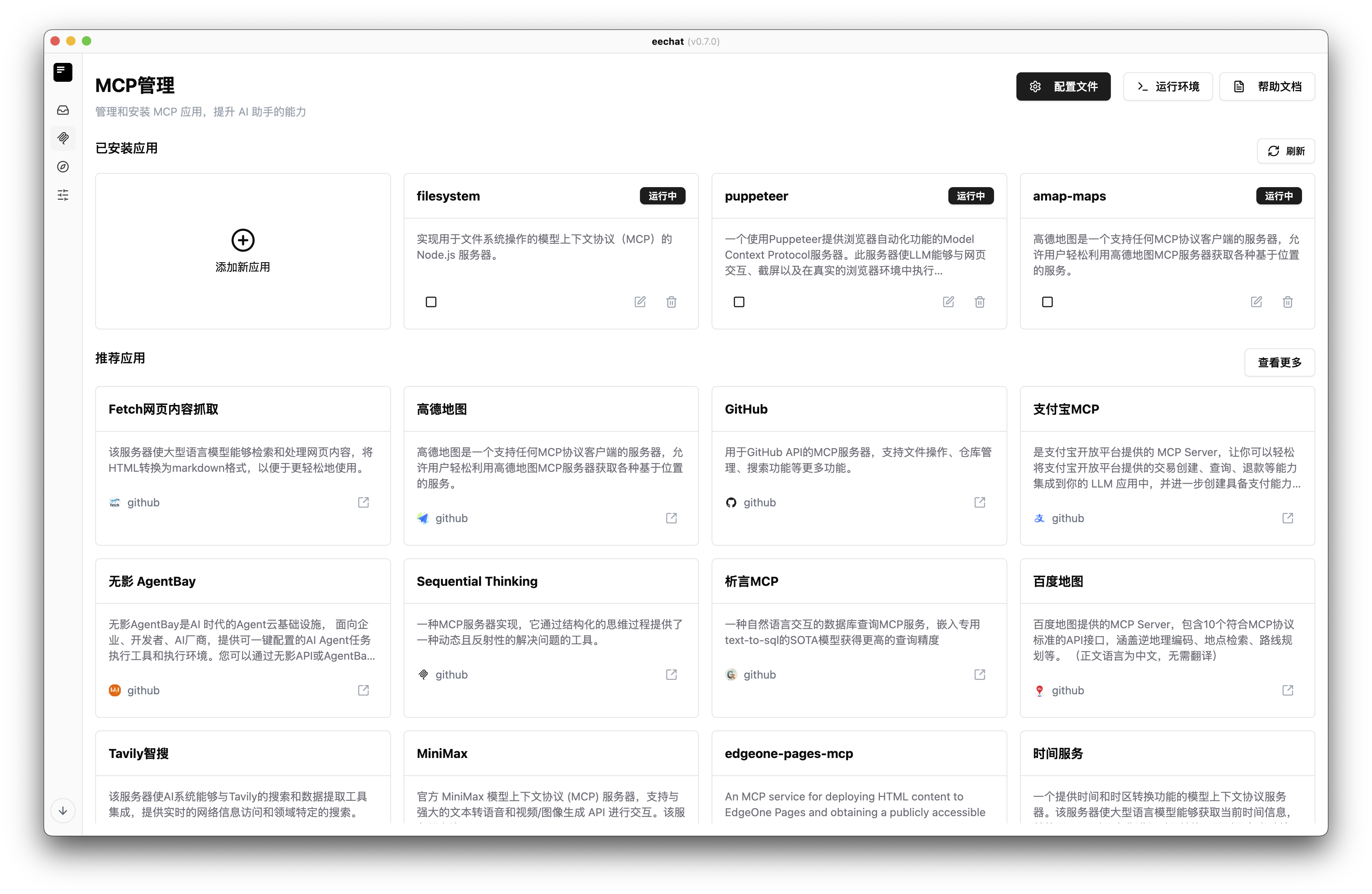

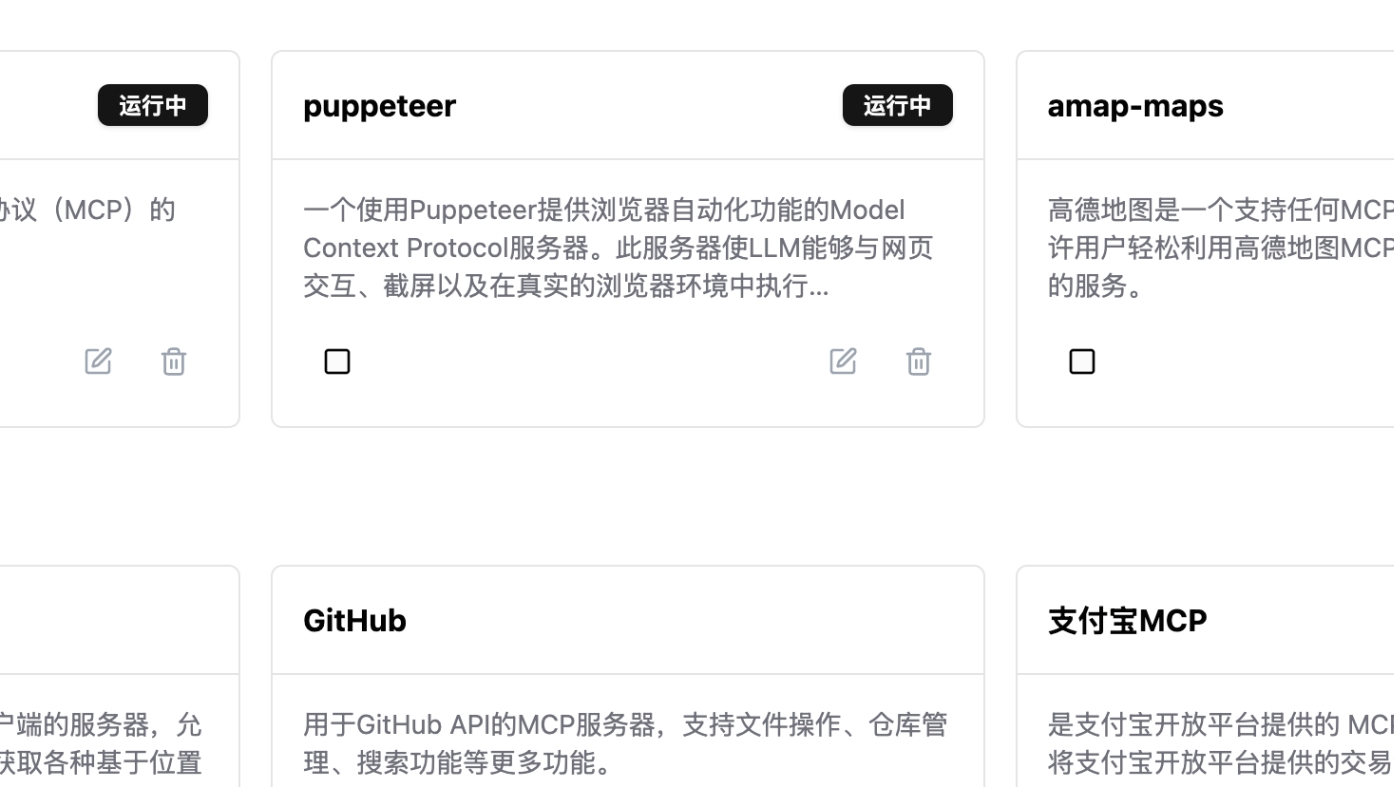

一键集成、管理、运行多种 AI 工具与服务,让 AI 助手能力无限拓展

可视化添加新 MCP 应用,支持自动读取 README 或 AI 智能填充配置

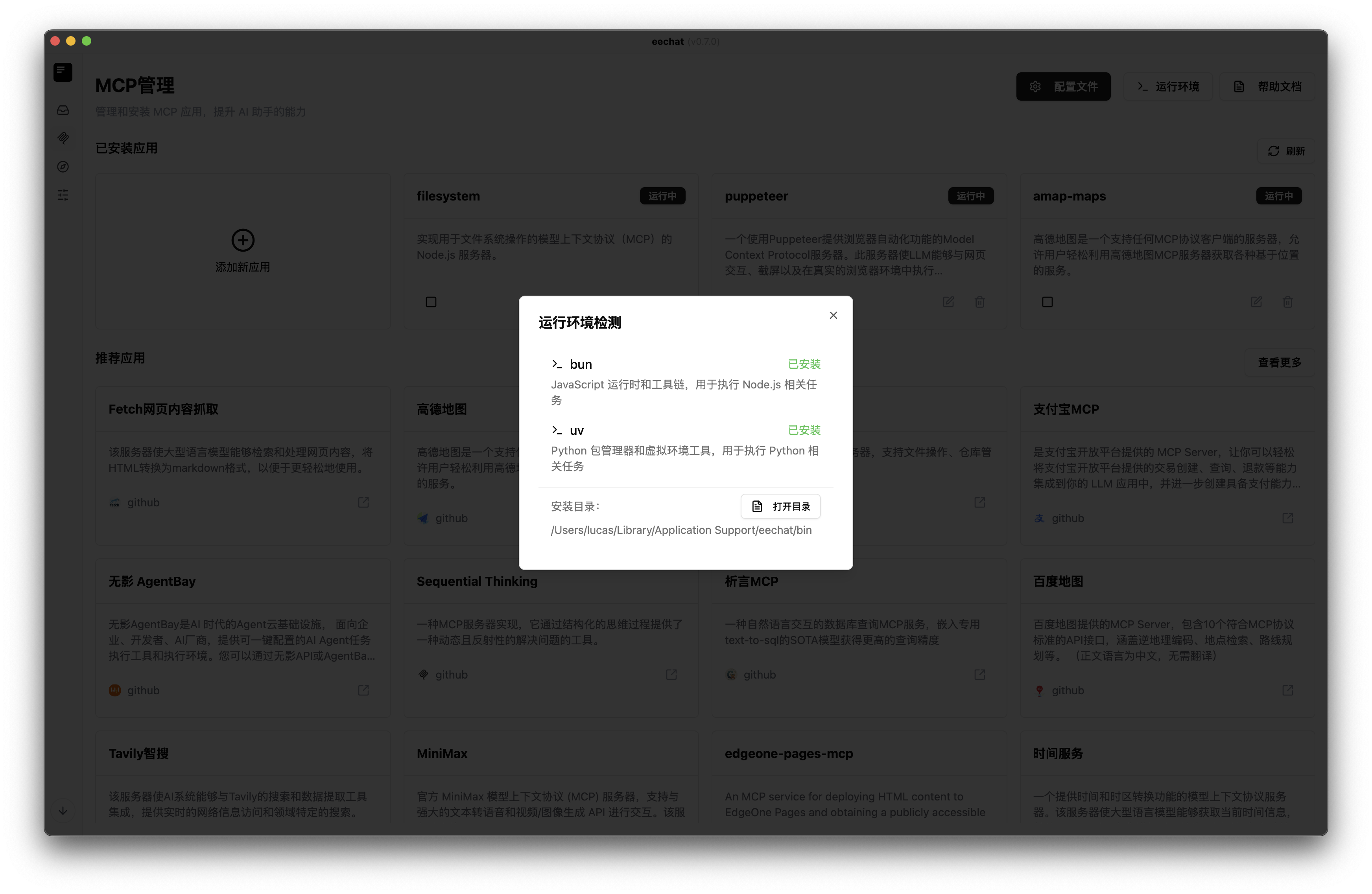

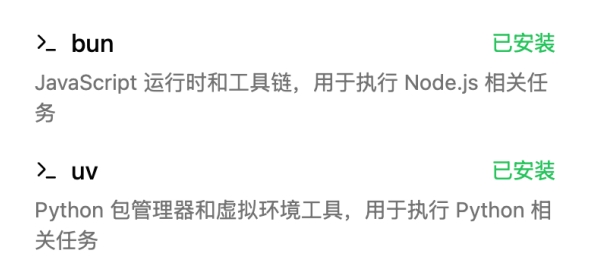

内置 bun、uv 等运行环境自动检测与一键下载,无需手动配置依赖

MCP 工具热插拔,可随时添加、移除、升级,支持多实例并行运行

轻松查看、安装、启动、停止和删除各类 AI 工具,无需命令行操作

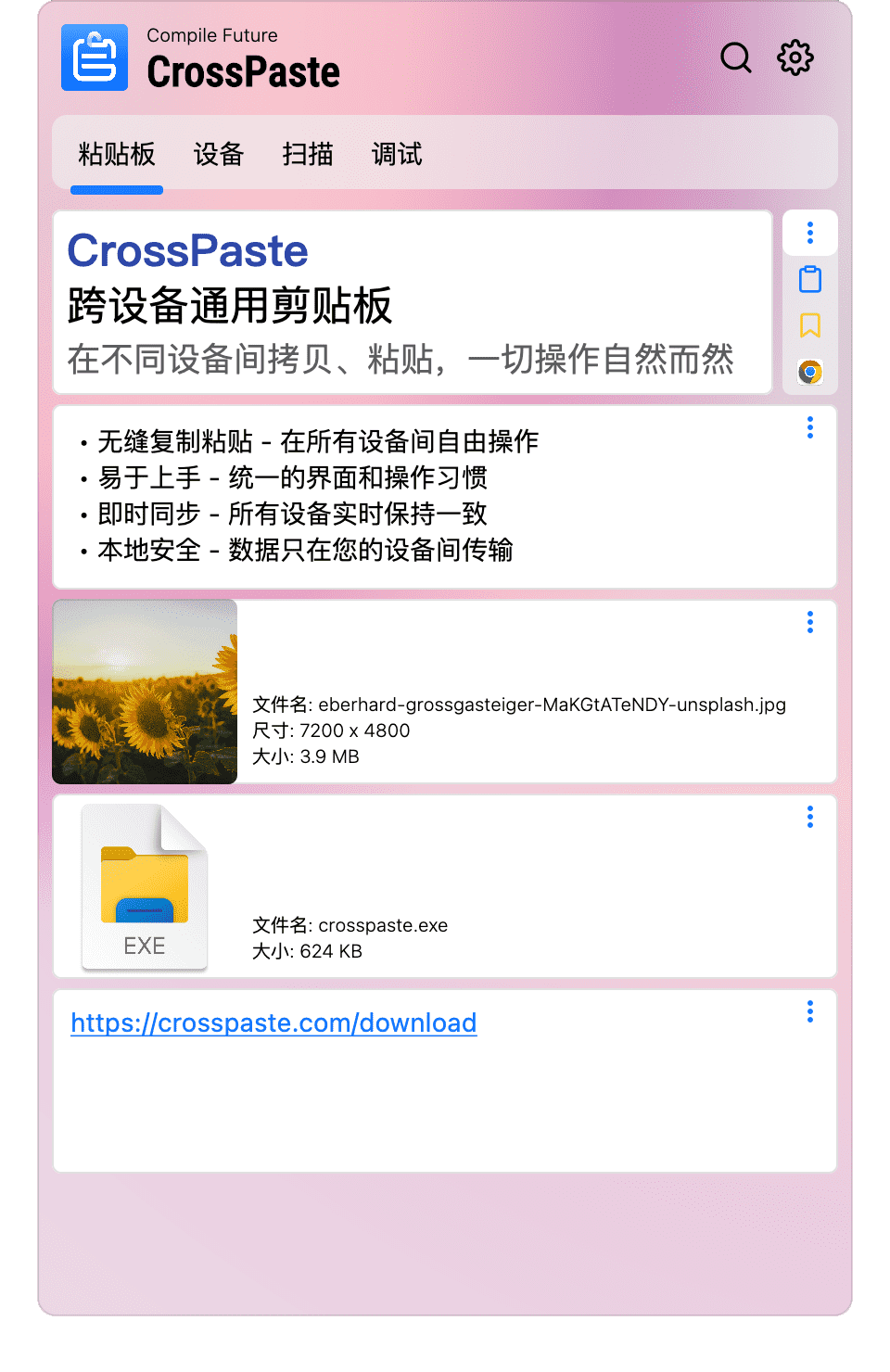

可视化配置

提供表单式可视化添加新 MCP 应用,支持自动读取 README 或 AI 智能填充配置,适合零基础用户快速集成新工具。

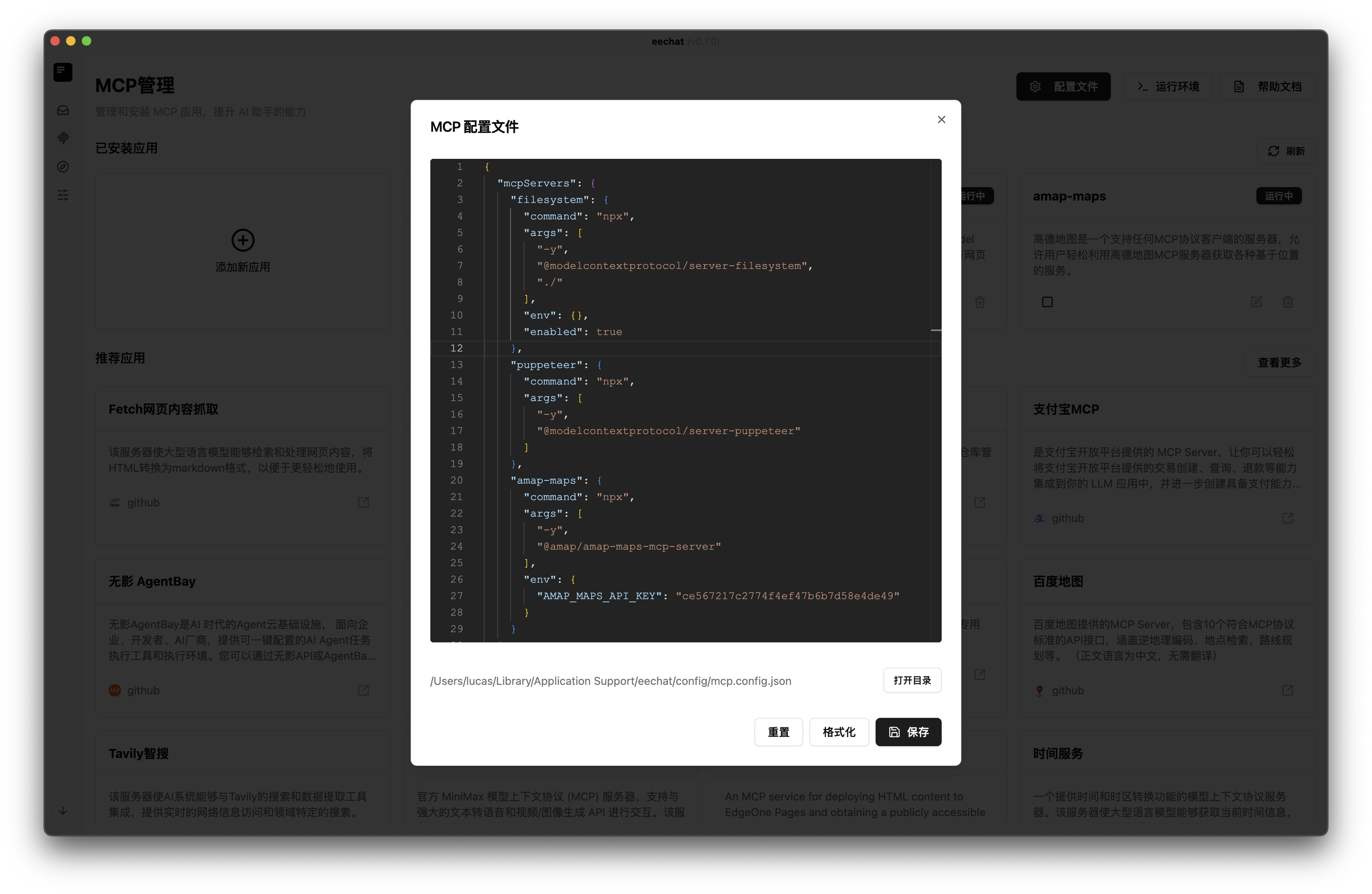

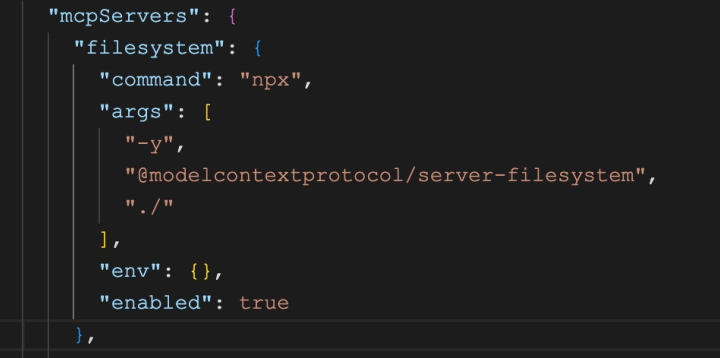

专业文件配置

内置专业 JSON 配置文件编辑器,支持格式化、重置、目录直达,满足进阶用户批量管理和深度定制需求。与Claude Desktop, Cursor, Cline 配置同步兼容。

集成运行环境

内置 bun、uv 等运行环境自动检测与一键下载,无需手动配置依赖,保障各类 Node.js/Python 工具即装即用。

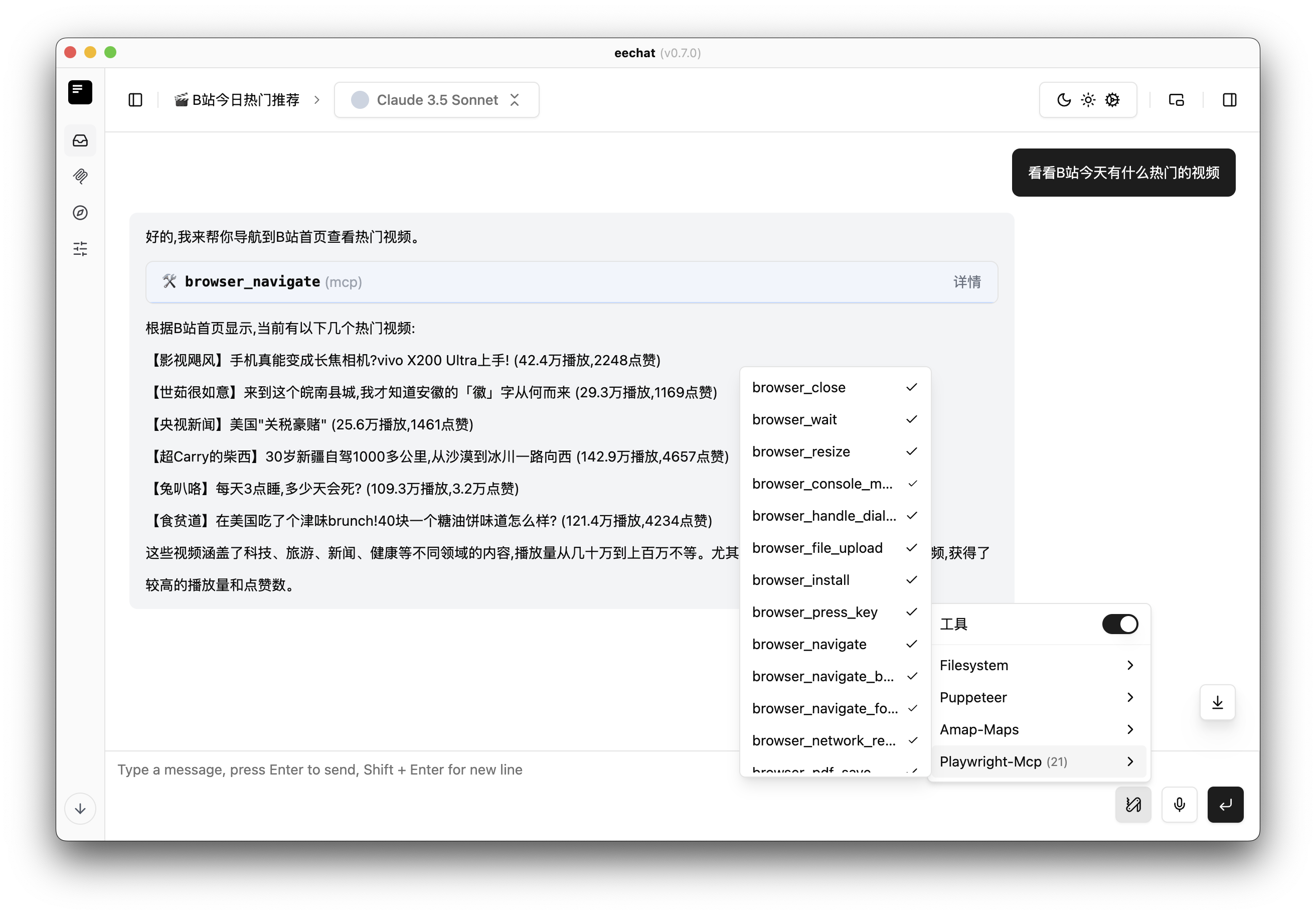

对话工具调用

所有 MCP 工具均可在聊天窗口直接调用,实现 AI 与工具的无缝协作。

对话工具一键开关,随时切换工具状态

多工具并行,支持多轮对话

支持的模型

eechat 支持广泛的本地和基于 API 的模型,以满足您的需求。

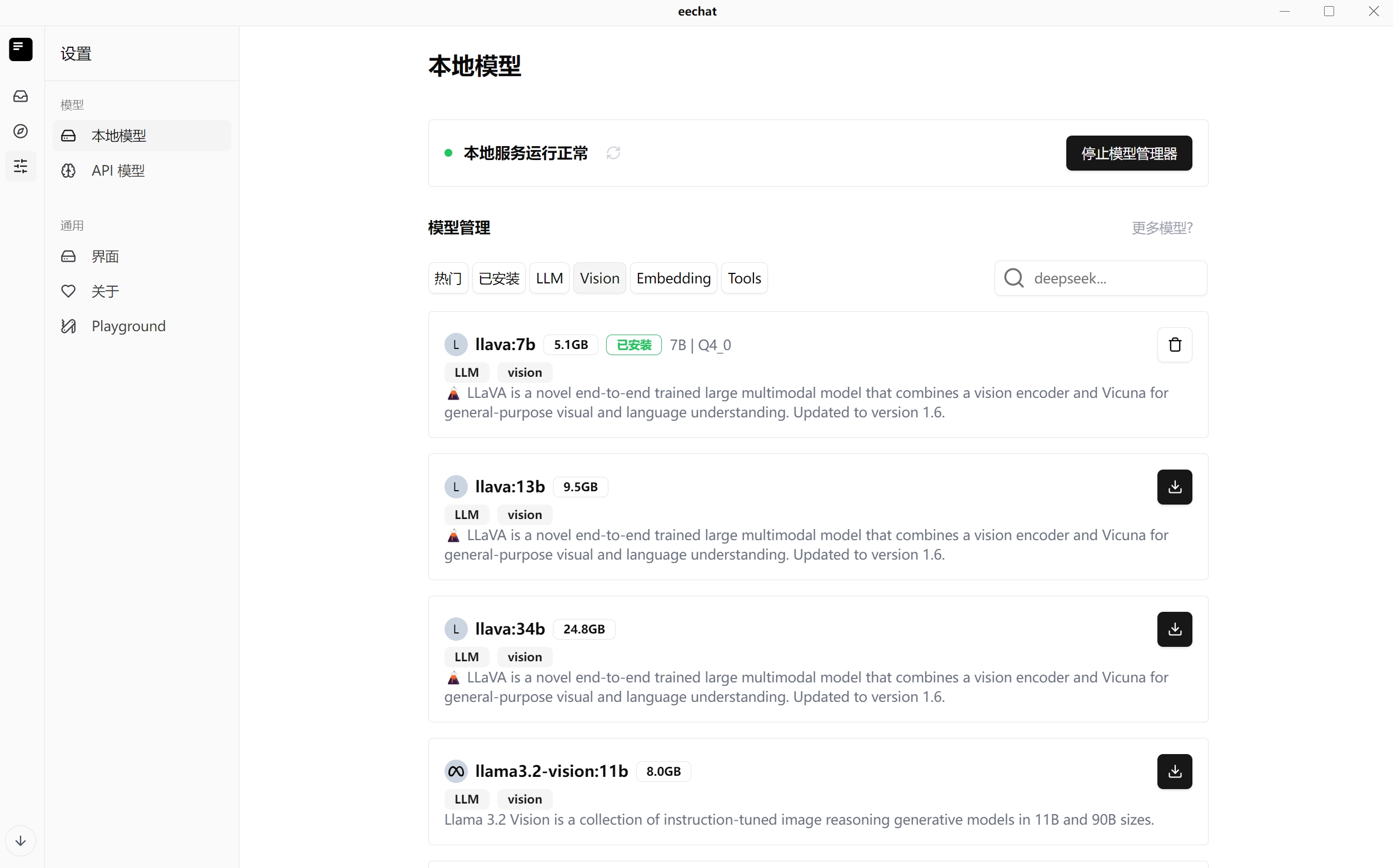

本地模型

LLaVA

结合视觉编码器和 Vicuna 的多模态模型,用于视觉和语言理解。

Llama

各种尺寸的指令调优图像推理生成模型集合。

DeepSeek

与 OpenAI-o1 性能相当的第一代推理模型。

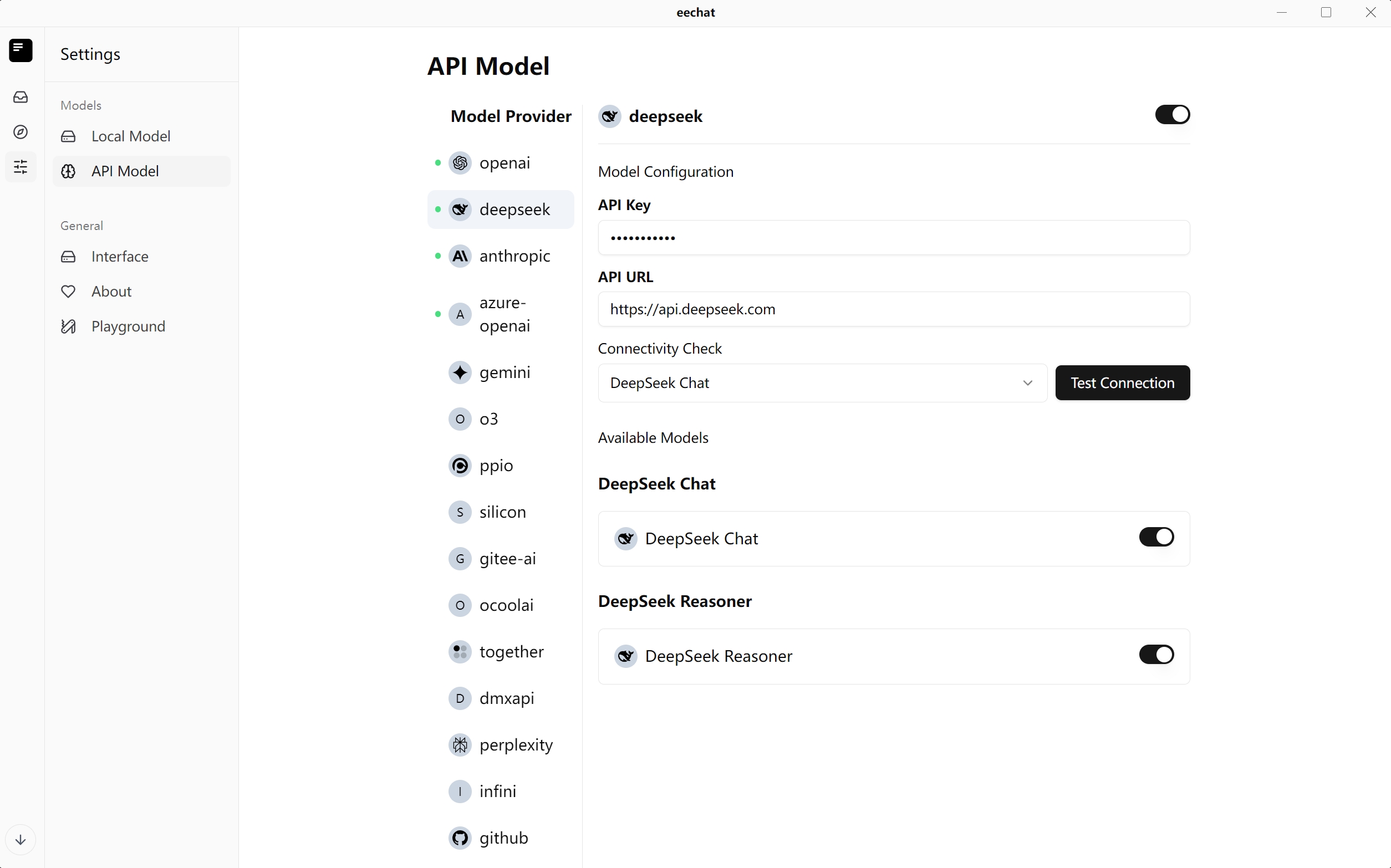

API 模型

OpenAI

连接到 OpenAI 的 GPT 模型,包括 GPT-3.5 和 GPT-4。

DeepSeek

通过 API 访问 DeepSeek 强大的语言模型。

Anthropic

集成 Anthropic 的 Claude 模型,用于高级推理。

更多模型

支持 Gemini、Together、Perplexity 和其他领先的 AI 提供商。